“周易”X3 NPU精准解决端侧AI大模型运行难题

2025-11-20

来源:安谋科技

编者按:2025 年 11 月 13 日,安谋科技(Arm China)“周易”X3 NPU IP新品。作为“All in AI”产品战略下诞生的首款重磅产品,其性能指标表现突出:8-80 FP8 TFLOPS、单Core带宽256GB/s、Prefill算力利用率达72%和Decode有效带宽利用率超100%,可使AIGC大模型能力提升10倍。

随着AI大模型技术的飞速发展,智能手机、AI PC和智能汽车等端侧设备正迎来AI能力的爆发性需求。从多模态语音助手到实时图像生成,从智能座舱交互到辅助驾驶决策,端侧设备需要承载越来越复杂的AI计算任务。

然而,端侧AI部署面临算力受限、能效要求高、带宽瓶颈、开发门槛高等多重挑战,如何在有限的功耗和算力资源下实现大模型的高效运行,成为行业亟需突破的关键难题。

众所周知,在半导体领域,“面向未来5年的产品方向进行前瞻布局”已成为行业共识,涵盖IP研发、芯片及终端产品研发量产。

因需而动,安谋科技的“周易”X3采用兼顾CNN与Transformer的通用架构设计,支持全算力类型并增强浮点运算FLOPS,助力实现从定点到浮点计算的关键转变,并满足大模型计算需求,为未来5年Gen AI、Agentic AI与Physical AI的端侧落地奠定技术基石。

硬件架构:专为大模型设计最新DSP+DSA架构

“周易”X3基于专为大模型设计的最新DSP+DSA架构,从计算效率、带宽、精度适配、任务处理四大维度实现升级,精准解决端侧AI大模型运行难题,打造端侧AI计算效率的新标杆。

从定点转向浮点计算,单Cluster拥有8-80 FP8 TFLOPS算力且可灵活配置,单Core带宽高达256GB/s,支持端侧大模型运行必备的W4A8/W4A16计算加速模式,集成安谋科技自研的解压硬件WDC,使大模型Weight软件无损压缩后通过硬件解压获得额外约15%的等效带宽,计算效率和计算密度大幅提升。

同时,“周易”X3集成AI专属硬件引擎AIFF,配合专用硬化调度器,实现超低至0.5%的CPU负载与低调度延迟,使NPU在并行处理多项AI任务时,拥有高效流畅的体验。

软件生态:优化大模型端到端性能,支持客户自定义AI开发

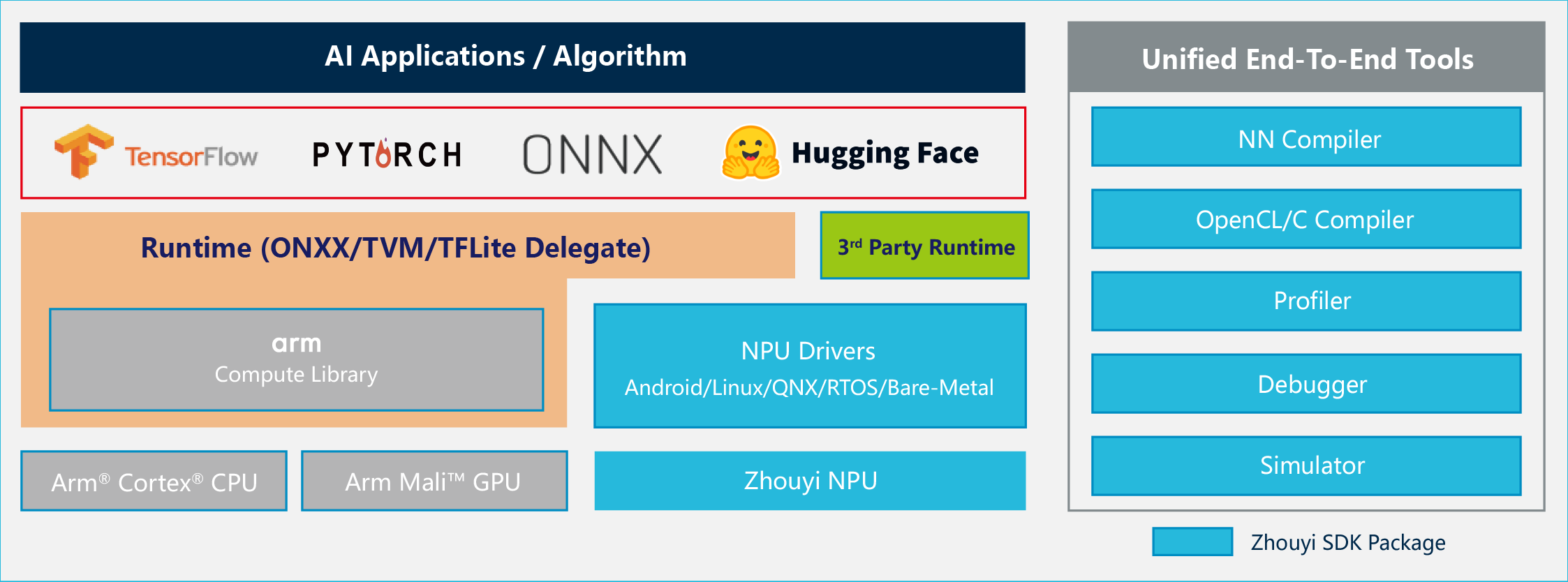

“周易”X3 搭载完善易用的Compass AI软件平台,全面优化大模型端到端性能。平台广泛兼容TensorFlow、ONNX、PyTorch等主流AI框架,具备业界领先的大模型动态Shape支持能力,并支持GPTQ等大模型主流量化方案、 Hugging Face模型库,与LLM、VLM、VLA及MoE等模型。

同时,安谋科技积极构建开放生态,Compass AI软件平台已将 Parser、Optimizer、Linux Driver、TVM 及内部 IR 格式等核心组件相继开源,并拥有丰富的调试工具,可满足开发者白盒部署需求,且支持更易用的 DSL 算子编程语言,在深度开发模式下,客户可以使用平台中的Compiler、Debugger和DSL语言开发出自己的自定义算子,也可通过Parser、Optimizer等工具打造出属于自己的模型编译器,极大提升开发效率。

“周易”Compass AI软件平台已支持超 160 种算子与 270 多种模型,显著提升开发部署效率,助力客户快速实现 AI 应用创新与落地。

性能提升:让端侧大模型“跑得稳、答得顺”

“周易”X3遵循“软硬协同、全周期服务与成就客户”的产品准则,提供从硬件、软件到售后服务的全链路支持,以前瞻性设计、专业团队交付与深度服务投入,全面助力客户大模型产品成功与商业化落地。

“周易”X3在架构层面实现了多项创新,集成了业界瞩目的关键特性。

1.集成自研解压硬件WDC:使大模型Weight软件无损压缩后通过硬件解压能获得额外15%~20%等效带宽提升。

2.新增端侧大模型运行必备的W4A8/W4A16计算加速模式:对模型权重进行低比特量化,大幅降低带宽消耗,支持云端大模型向端侧的高效迁移。

3.集成AI专属硬件引擎AIFF(AI Fixed-Function)与专用硬化调度器:实现超低至0.5%的CPU负载与低调度延迟,灵活支持端侧多任务场景和任意优先级调度场景,确保高优先级任务的即时响应。

4.支持int4/int8/int16/int32/fp4/fp8/fp16/bf16/fp32多精度融合计算,强浮点计算:可灵活适配智能手机边缘部署、AI PC推理、智能汽车等从传统CNN到前沿大模型的数据类型需求,平衡性能与能效。

在上述关键技术的加持下,“周易”X3获得了优异的计算性能:单Cluster最高支持4个Core,拥有8-80 FP8 TFLOPS算力且可灵活配置,单Core带宽高达256GB/s。相较于“周易”X2产品,“周易”X3的CNN模型性能提升30%-50%,多核算力线性度达到70%-80%。在同算力规格下,AIGC大模型能力较上一代产品实现10倍增长,这得益于16倍的FP16 TFLOPS、4倍的计算核心带宽、超过10倍的Softmax和LayerNorm性能提升共同驱动。

借助“周易”X3的超能力,端侧大模型推理将更高效。

实测结果表明,在Llama2 7B大模型实测中,“周易”X3 NPU IP在Prefill阶段算力利用率高达72%,并在安谋科技Arm China自研的解压硬件WDC的加持下,实现Decode阶段有效带宽利用率超100%,远超行业平均水平,满足大模型解码阶段的高吞吐需求。

总结

“周易”X3 NPU IP的发布,标志着安谋科技Arm China“All in AI”产品战略的正式开启。从“周易”Z1的基础感知到“周易”X3的复杂认知,这一技术演进路径清晰地表明,端侧AI正在从单一的功能实现,迈向融合多种模型、适应动态场景的“全民普及”新阶段